前面一篇文章给大家介绍了常见的AIGC模型都有哪些,链接如下:

今天接着分享一下在AIGC的应用中典型的深度学习网络。

1、生成对抗网络

生成对抗网络网络(Generative Adversarial Network,GAN),是深度学习领域的一个重要里程碑。它可以帮助神经网络用更少的数据进行学习,生成更多的合成图像,之后还可以用来识别和建设更好的神经网络。

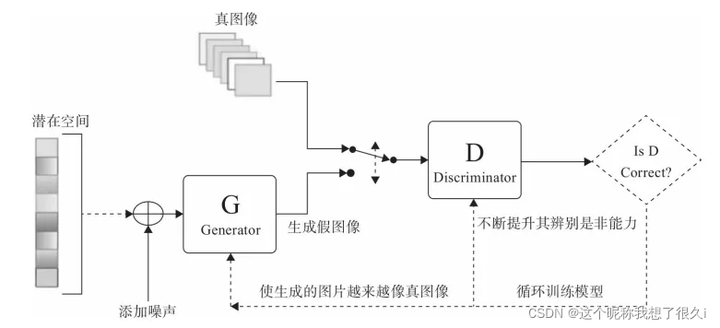

主要思路是由两个神经网络来玩“猫捉老鼠”的游戏。一个是生成器,另一个是判别器。生成器用来创造出看起来像真实图像的假图像,而判别器则用来判断它们是否是真的。如图下图:

在相互对抗中,生成器生成的图像逐渐达到以假乱真的地步,从而让判别器难以判断真假,使得生成的数据分布更加接近真实数据分布。

GAN 有助于创建图像,还可以创建现实世界的软件虚拟场景,例如英伟达就是采用大量的生成对抗网络技术来增强虚拟现实模拟系统的。

GAN 的最大优势是其不依赖于先验假设,而是通过迭代的方式逐渐学习到数据的分布。因此,目前 GAN 已经广泛应用在媒体、广告、游戏、娱乐等行业,可以用来创造虚构的任务、画面,模拟人脸老化、图像风格变换以及产生化学分子式等。早期的 GAN 生成图像的效果比较一般,但研究人员加快创新和进一步优化模型,尤其是 StyleGAN 出现让生成的图像足以以假乱真。

下图中的人脸全部都是由GAN模型自动生成的,值得注意的是,这些人脸并不是从真人的照片中修改而来,而是模型从零开始修改的全新人脸。

但是GAN也有一定的不足,主要集中在稳定性和收敛性方面。例如,GAN的生成器和判别器之间需要很好地同步,但是在实际训练中很容易出现判别器收敛而生成器发散的情况,因此两者的训练需要精心设计才能避免不同步的情况出现。另外,如果GAN模型对于输出结果的控制力不足,就容易产生随机图像,同时图像的分辨率也不高。更为重要的是,让生成的数据分布接近真实数据分布,还会产生新的问题,那就是生成的内容是非常接近现有的内容,但很难实现突破和创新。

2、Transformer

Transformer 是继 GAN 之后,深度学习领域的另一个重大研究成果。2017年谷歌和多伦多大学的研究人员共同发表了一篇著名的论文“Attention Is All You Need”,该论文提到了一个自然语言处理的模型Transformer。

Transformer 是一款基于自然语言的序列传导模型,论文简洁清晰地阐述了这个新的网络结构 Transformer 基于注意力机制,不需要进行递归和卷积,因此模型在质量上更胜一筹,需要的训练时间也减少了很多。

由于Transformer 诞生于自然语言理解领域,因此对人类语言的理解更加容易。

例如这句话:“青蛙发现了一只蝴蝶。它试图抓住它,但是只抓住了翅膀的末端。”

这里面第二个句子的结构令人困惑:“它”指的是什么?如果是卷积神经网络,则只会关注“它”周围的词,并不理解“它”到底指代的是什么。但是如果把每个词和其他词结合起来,就会发现这两句话是说“青蛙抓住了蝴蝶,蝴蝶失去了部分翅膀”。这种关联性就是Transformer模型中提到“Attention”机制,而且这种方法和人类思考模式很接近。

为什么这么说呢?

因为“Attention”机制模仿的就是人类视觉所特有的大脑信号处理机制。具体来讲,在看一幅图像或一段文字的时候,眼睛会快速扫描全局,找到需要重点关注的部门(即所谓的注意力焦点),之后再进一步对相关区域进行仔细观察。这是人类在长期进化中获得的一种生存技能,这种机制极大提高了我们信息处理的效率和准确性。

更进一步说,Transformer 的这个“Attention”机制,成功消除了训练数据集需要标注的需求,这一变化让互联网或者企业里的海量文本数据可以直接成为模型训练的数据源,这可以说是具有标志性的创新。

Transformer 是一个具备强大通用性的底层架构,2018 年在其基础上实现了第一款自然语言处理模型–BERT。BERT模型没有使用预先标记的数据库进行训练,而是采用了自我监督学习的方法进行。

当BERT模型在海量的文本中进行分析挖掘的时候,能够自行找到隐藏的单词或者根据上下文猜测其中的含义,这种做法和我们考试做题的思路很接近,非常类似于人类大脑学习的机制。之后这类模型又被其他人工智能机构广泛采用,在语言、视觉、多模态等领域,都有着很好的应用。

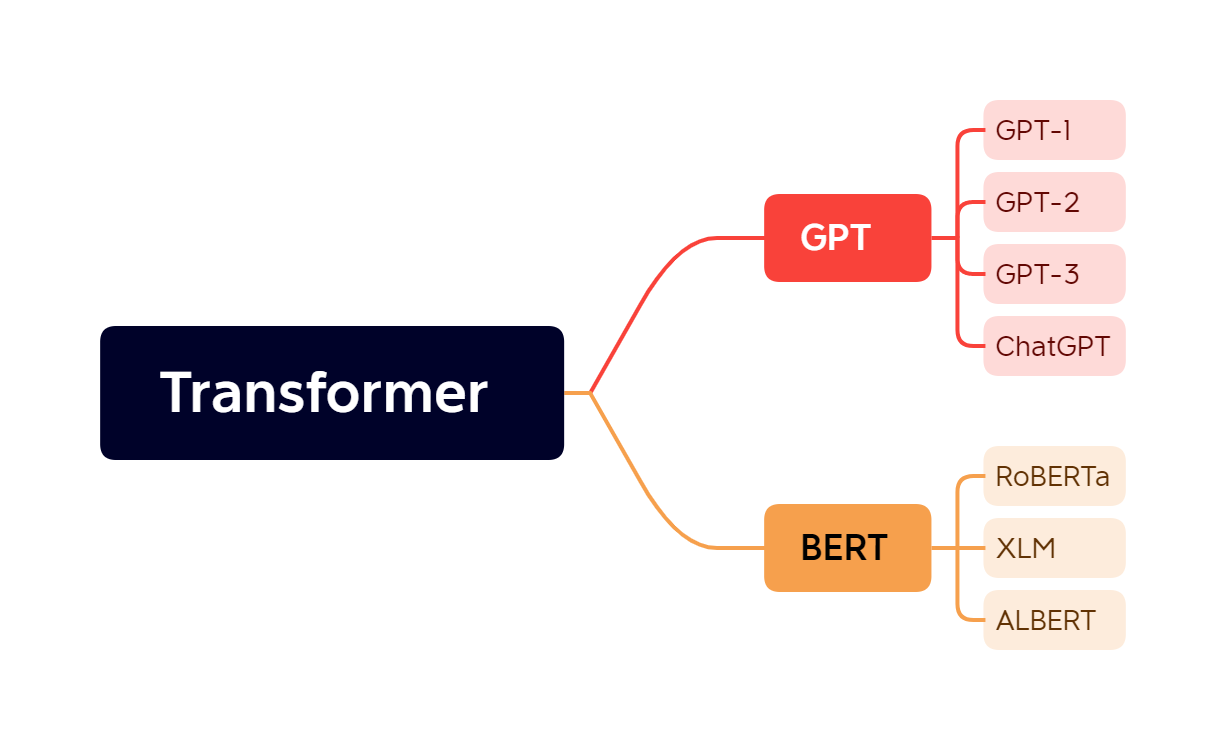

可以说Transformer语言模型在理解文本方面的能力实现了质的飞跃。我们现在熟知的很多模型都来自Transformer ,具体如下图所示:

自然语言是所有可训练数据中最丰富的,能够让基础模型在语境中学习、转换成各种内容形式,到 2019年,人工智能理解人类自然语言的水平就已经超过人类平均水平。

也就是说在这个时候,人工智能已经具备了“能听会看”,下一步的突破就是理解、思考和决策。也正因为如此,大规模语言模型(Large Scale Language Model,LSLM)成为新一轮科技巨头的竞争领域。